słownik pojęć marketingowych

Robots.txt – co to jest, definicja

Robots.txt – definicja. Co to jest?

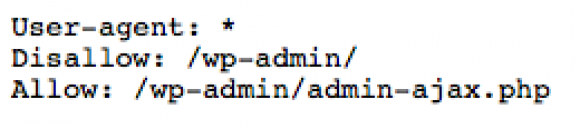

Plik robots.txt to specjalnie spreparowany dokument, odpowiadający za komunikowanie się z robotami indeksującymi, które przeczesują internet. Ich zadaniem jest odnajdywanie nowych stron internetowych, a także pozyskiwanie informacji na temat wprowadzanych modyfikacji. Ich treść opisuje również obszary witryny, które nie podlegają indeksacji i mają być niewidoczne w wynikach wyszukiwania. Są one pisane z użyciem specjalistycznego języka komend określonego standardem Robots Exclusion Protocol.

-

O

- Outsourcing, czyli co to?

- Opis kategorii, czyli co to?

- Opis produktu, czyli co to?

- Optymalizacja techniczna, czyli co to?

- Orphan Pages, czyli co to?

- Odsyłające domeny, czyli co to?

- Off-Site SEO, czyli co to?

- Okres ważności domeny, czyli co to?

- Omnichannel, czyli co to?

- On-Site SEO, czyli co to?

- Opera (przeglądarka), czyli co to?

- Operatory Google, czyli co to?

- Opinie Google, czyli co to?

- Odrzucone sesje, czyli co to?

- Obniżenie pozycji, czyli co to?

- Ochrona prywatności, czyli co to?

- Odnowienie domen, czyli co to?

- Organiczne wyniki Google (inaczej bezpłatne, naturalne), Ruch organiczny

- Organic traffic – co to jest, definicja

- Optymalizacja pod wyszukiwarki – co to jest, definicja

- Outbound marketing – co to jest, definicja

- Open Source – co to jest, definicja

- Organiczne wyniki Google (inaczej bezpłatne, naturalne), Ruch organiczny

-

p

- Public relations, czyli co to?

- Proxy, czyli co to?

- PrestaShop, czyli co to?

- Promocja strony internetowej, czyli co to?

- Pozycjonowanie lokalne, czyli co to?

- Profil linków, czyli co to?

- PPS, czyli co to?

- Prędkość strony, czyli co to?

- Presell Pages, czyli co to?

- Przeglądarka internetowa, czyli co to?

- PPA (Pay Per Action), czyli co to?

- PPL, czyli co to?

- Psychologia marketingu, czyli co to?

- Przyjazny adres URL, czyli co to?

- Psychologia reklamy, czyli co to?

- Python, czyli co to?

- PWA, czyli co to?

- Powracający użytkownicy, czyli kto to?

- Porzucony koszyk, czyli co to?

- Podcast, czyli co to?

- Plik .htaccess, czyli co to?

- Planer Słów Kluczowych, czyli co to?

- Pillar page, czyli co to?

- Piksel Facebook, czyli co to?

- PHP, czyli co to?

- Phantom Google, czyli co to?

- Personal Brand, czyli co to?

- PostgreSQL, czyli co to?

- Page Authority, czyli co to?

- Permission Marketing, czyli co to?

- People Also Ask, czyli co to?

- Performance Max, czyli co to?

- Penalizacja, czyli co to?

- Payday loan, czyli co to?

- Partnerzy Google, czyli kto to?

- Paragraf 31, czyli co to?

- Pamięć cache, czyli co to?

- Paginacja, czyli co to?

- Paid Search, czyli co to?

- PageSpeed Insights, czyli co to?

- SEA (Search Engine Advertising) – co to jest, definicja

- Page rank – co to jest, definicja

- PPC (ang. Pay Per Click) – co to jest, definicja

- Przekierowanie 302 – co to jest, definicja

- Przekierowanie 301 – co to jest, definicja

- Personalizacja wyników wyszukiwania – co to jest, definicja

- Partial match anchor – co to jest, definicja

- Presell pages – co to jest, definicja

- Pingwin Google – co to jest, definicja

- Pingowanie – co to jest, definicja

- q

-

r

- Rozdzielczości ekranu, czyli co to?

- Rozszerzenia cen, czyli co to?

- Rozszerzenia formularzy kontaktowych, czyli co to?

- Rozszerzenie lokalizacji, czyli co to?

- Rozszerzenie objaśnień, czyli co to?

- Rozszerzenie połączeń, czyli co to?

- Rozszerzenie promocji, czyli co to?

- RSS, czyli co to?

- Ruby, czyli co to?

- Ruch referencyjny, czyli co to?

- RAM, czyli co to?

- Rank Brain, czyli co to?

- RLSA, czyli co to?

- REST, czyli co to?

- Remarketing, czyli co to?

- Reklama kontekstowa, czyli co to?

- Responsywna strona, czyli co to?

- Rank Math SEO, czyli co to?

- Real time marketing, czyli co to?

- Reklama natywna, czyli co to?

- Reklama społeczna, czyli co to?

- Rebranding, czyli co to?

- ROAS, czyli co to?

- ReCAPTCHA, czyli co to?

- Recykling treści, czyli co to?

- Referral, czyli co to?

- Reklama elastyczna (responsive ads), czyli co to?

- Reklama komercyjna, czyli co to?

- Rich snippets – co to jest, definicja

- Referrer – co to jest, definicja

- RDFa – co to jest, definicja

- Rankbrain – co to jest, definicja

- ROPO (ang. research online, purchase offline) – co to jest, definicja

- ROI (ang. return on investment – zwrot z inwestycji) – co to jest, definicja

- RODO – co to jest, definicja

- Robots.txt – co to jest, definicja

- Responsive Web Design (RWD) – co to jest, definicja

- Remarketing (Retargeting) – co to jest, definicja

- Reklama displayowa – co to jest, definicja

-

S

- Syndykacja treści, czyli co to?

- SXO, czyli co to?

- Strona wyjścia, czyli co to?

- Strony dynamiczne, czyli co to?

- Strona wejścia, czyli co to?

- SWOT, czyli co to?

- Struktura nagłówków, czyli co to?

- Strony internetowe, czyli co to?

- Szybkość ładowania, czyli co to?

- Systemy płatności, czyli co to?

- Strony statyczne, czyli co to?

- Strony partnerskie, czyli co to?

- Szyfrowanie danych, czyli co to?

- Subdomena, czyli co to?

- Słowo kluczowe, czyli co to?

- Sitelinks, czyli co to?

- Skalowalność, czyli co to?

- Silosy tematyczne, czyli co to?

- Slogan reklamowy, czyli co to?

- Sprawdzenie responsywności, czyli co to?

- SMO (Social Media Optimization), czyli co to?

- Specjalista SEO, czyli kto to?

- Statystyki odwiedzin, czyli co to?

- SQLite, czyli co to?

- Strona główna, czyli co to?

- SMM, czyli co to?

- Strategia marketingowa, czyli co to?

- Storytelling, czyli co to?

- Spam Score, czyli co to?

- Stopka, czyli co to?

- Strategia pozycjonowania, czyli co to?

- Strona kontaktowa, czyli co to?

- SOAP, czyli co to?

- Strona produktowa, czyli co to?

- SERP, czyli co to?

- Semstorm, czyli co to?

- Senuto, czyli co to?

- SEOquake, czyli co to?

- Service Design, czyli co to?

- Serwer DHCP, czyli co to?

- Sesja, czyli co to?

- Shoper, czyli co to?

- Sieć wyszukiwania, czyli co to?

- Siatka powiązań, czyli co to?

- Sekcje witryny, czyli co to?

- Segmentacja, czyli co to?

- Search box, czyli co to?

- Scrum, czyli co to?

- SEM, czyli co to?

- Satelity, czyli co to?

-

t

- TTFB, czyli co to?

- Transfer domen, czyli co to?

- Thin content, czyli co to?

- TikTok, czyli co to?

- Time to Interactive, czyli co to?

- Tiny text, czyli co to?

- TITLE, czyli co to?

- TITLE tag, czyli co to?

- Topical authority, czyli co to?

- Trade marketing, czyli co to?

- Testy A/B, czyli co to?

- Techniki nieetyczne, czyli co to?

- Targetowanie geograficzne, czyli co to?

- Targetowanie demograficzne, czyli co to?

- Targetowanie socjograficzne, czyli co to?

- TLS – co to jest, definicja

- TLD – co to jest, definicja

- Target – co to jest, definicja

- Trust Rank – co to jest, definicja

- Targetowanie – behavioralne i kontekstowe – co to jest, definicja

-

u

- User Generated Content, czyli co to?

- Usunięcie z indeksu, czyli co to?

- Usuwanie sztucznych linków, czyli co to?

- Uszkodzone linki, czyli co to?

- UTM generator, czyli co to?

- Utrzymanie strony, czyli co to?

- Użyteczność strony, czyli co to?

- Uczenie maszynowe (Machine learning), czyli co to?

- Ubersuggest, czyli co to?

- UI, czyli co to?

- Unikalna treść, czyli co to?

- Up-selling, czyli co to?

- URL Rating, czyli co to?

- User agent, czyli co to?

- User-Agent – co to jest, definicja

- UX (ang. User experience) – co to jest, definicja

- USP (ang. Unique Selling Proposition) – co to jest, definicja

- Usability – co to jest, definicja

- URL, adres URL (ang. Uniform Resource Locator) – co to jest, definicja

- Unikalni użytkownicy (Unique Visitors) – co to jest, definicja